Experimentelle Ergebnisse

Als Daten für das neuronale Netz habe ich insgesamt 200 zweidimensionale binäre Bilder von 40 verschiedenen handgeschriebenen Zeichen benutzt, die je 64 x 64 Pixels groß sind. Dabei wird ein schwarzes Pixel durch 0 und ein weißes durch 1 präsentiert. Danach wurde jedes Zeichen in einen 4096 x 1 Vektor umgewandelt. Anschließend habe ich alle Zeichen jenes Input als 4096 x 40 Vektor für das System zusammengepackt und den Ausgabevektor definiert.

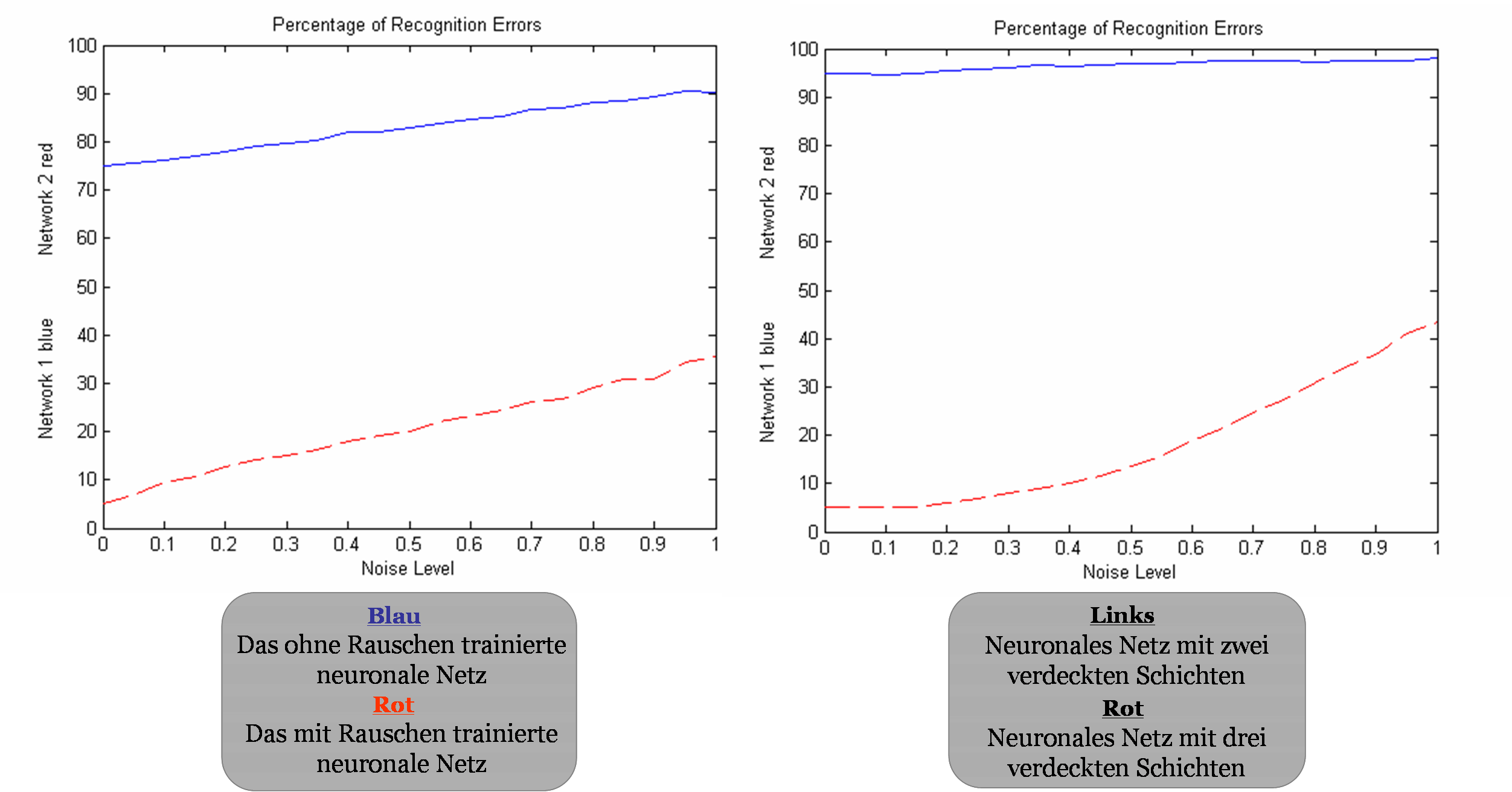

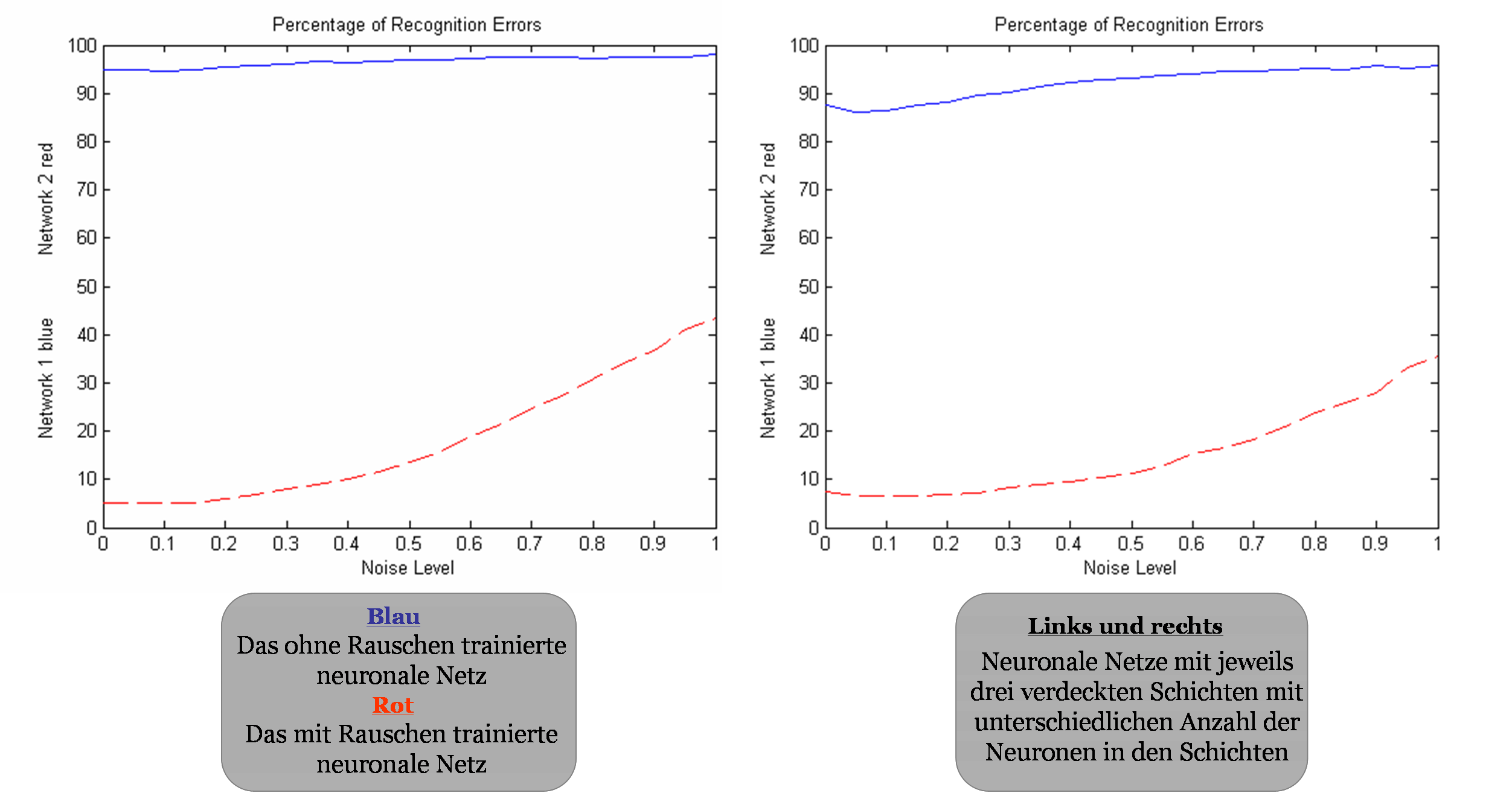

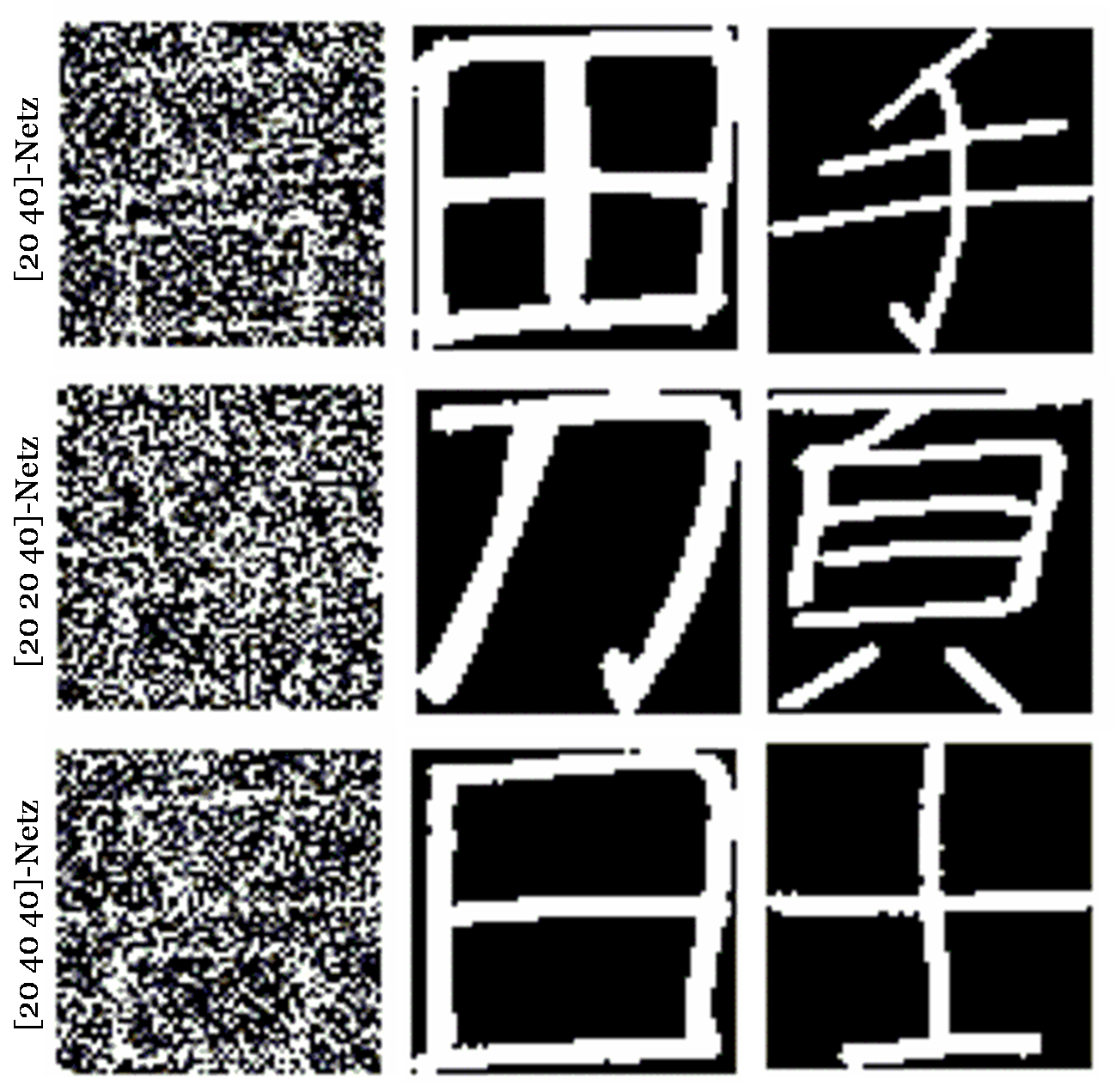

Zur Analyse der Leistungsfähigkeit der neuronalen Netze habe ich verschiedene multilayer Netze definiert, sie mit und ohne Rauschen trainiert und anschließend ihr Verhalten bei unterschiedlichen noise levels untersucht. Meines Erachtens nach kann man bei einem Netz mit mehr verdeckten Schichten oder höherer Anzahl der Neuronen pro Hidden-Layer keine signifikante Leistungssteigerung feststellen.Vergleich der Fehlerrate:

- Zwei Hidden-Layer-Netz vs. drei Hidden-Layer-Netz

- Drei Hidden-Layer-Netz mit unterschiedlicher Anzahl der Neuronen pro Schicht

Vergleicht man die Fehlerrate der neuronalen Netze aus den letzten Abbildungen kann man meiner Meinung nach keinen eindeutigen Zusammenhang zwischen der Anzahl der Hidden-Layers und den Neuronen pro Schicht finden. Anderseits hat sich die Vermutung bestättigt, dass mit Rauschen tranierte Netze deutlich bessere Ergebnisse liefern.

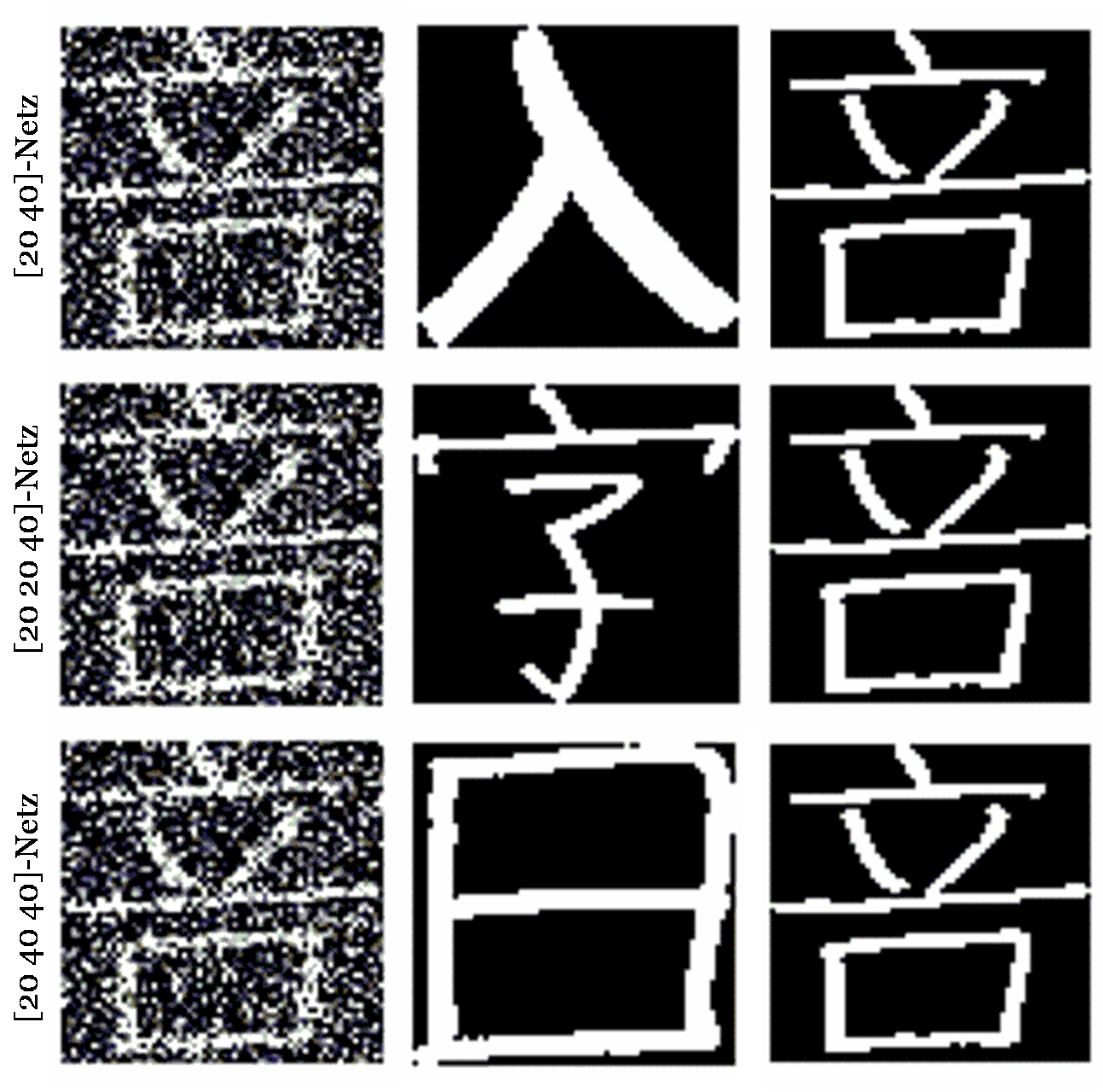

Beispiel mit einem Schriftzeichen mit dem gleichen noise level:

Beispiel mit einem Schriftzeichen mit unterschiedlichen noise levels:

Die letzten Behauptungen wurden ebenfalls durch die Untersuchung mit einem bestimmten Zeichen bestätigt. Trotz weniger Schichten oder Neuronen in den Schichten muss ein Netz nicht unbedingt niedrige Leistungsfähigkeit haben. Die Qualität der Vorhersagen hängt vor allem von den Trainingsdaten ab - wie sie gesammelt oder manuell erzeugt wurden. Dieser Vorgang kann allerdings sehr schwierig sein.